¡Inscribirme!

El Bosque Digital

El Bosque Digital te conecta con las herramientas y recursos esenciales para tu vida académica

Inscripciones

Inicia tu proceso de formación con El Bosque y comienza a forjar tu futuro profesional con calidad, compromiso y responsabilidad.

Financiación

Descubre planes de pago, créditos y convenios para hacer realidad tus estudios.

- Inscripciones

- Programas Académicos

- Facultades

- Facultad de Ciencias

- Facultad de Ciencias Económicas y Administrativas

- Facultad de Ciencias Jurídicas y Políticas

- Facultad de Creación y Comunicación

- Facultad de Educación

- Facultad de Enfermería

- Facultad de Ingeniería

- Facultad de Medicina

- Facultad de Odontología

- Facultad de Psicología

- Departamento de Bioética

- Departamento de Humanidades

- Vida Universitaria

- Investigación

- Nuestro Bosque

El Bosque en contexto

Categorias

¿Hablas con la inteligencia artificial sobre tu salud mental y no con tu psicólogo?

Autor: Comunicaciones

16 de Julio de 2025

Tiempo de lectura: 3 minutos

Más jóvenes recurren a chatbots, como ChatGPT, cuando no pueden acceder a un profesional en psicología. Exploramos los límites y alcances del acompañamiento digital.

Como en la película Her, donde una voz artificial ofrece escucha y compañía en un mundo solitario, cada vez más personas —especialmente jóvenes— dicen acudir a un chatbot como ChatGPT cuando atraviesan momentos de angustia o tristeza. En lugar de escribir a un amigo o pedir una cita con una persona profesional en psicología, deciden hablar con una herramienta de inteligencia artificial (IA). Este fenómeno, que a simple vista puede parecer curioso o inquietante, refleja transformaciones profundas en la forma en que buscamos acompañamiento emocional.

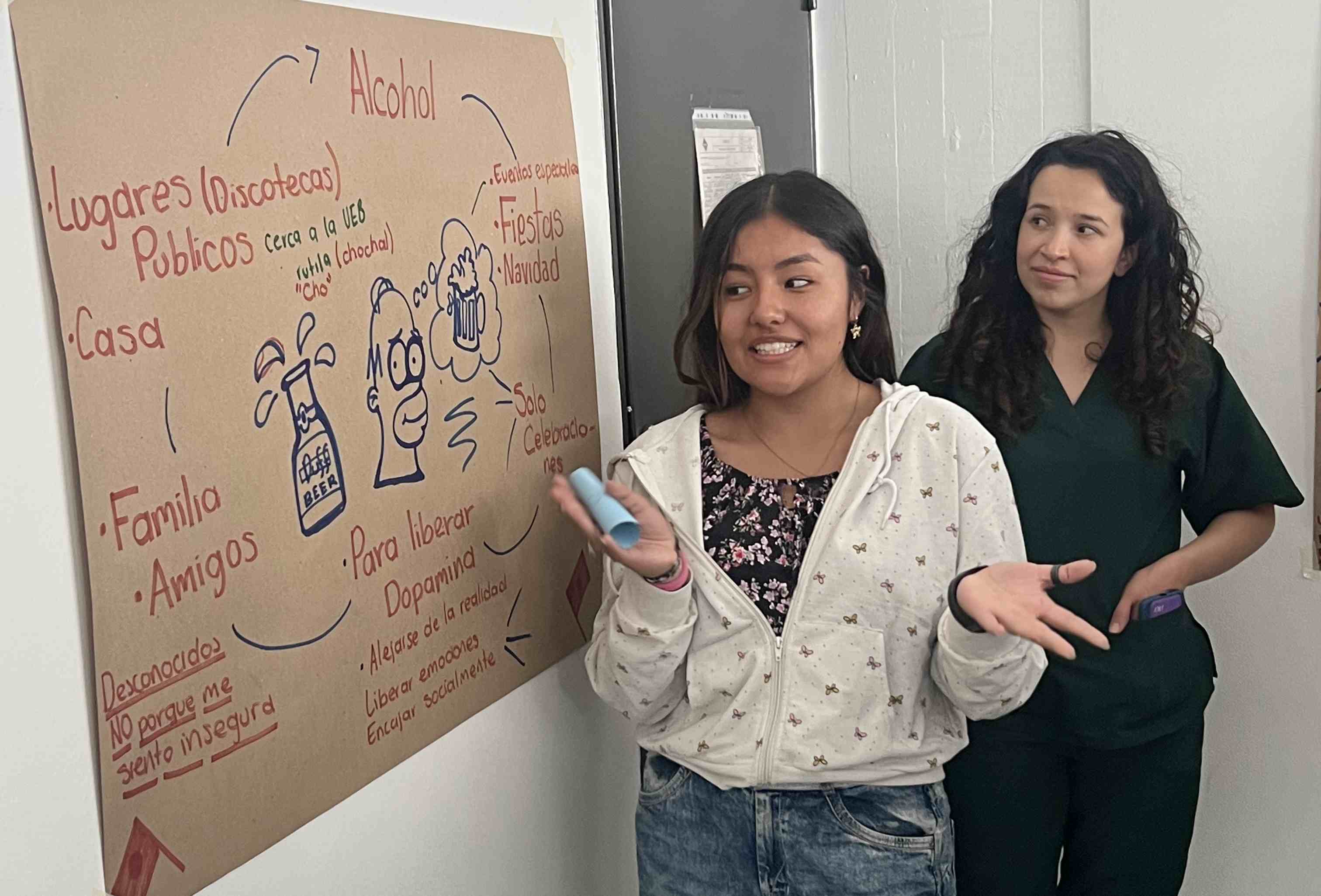

Desde la Facultad de Psicología de la Universidad El Bosque, la docente Rubby Castro Osorio, investigadora en salud digital y bienestar, observa que estos espacios tecnológicos están cumpliendo una función real y legítima: la necesidad de sentir que nos escuchan, incluso por una inteligencia no humana.

Te puede interesar: Investigación revela brechas en cuidados paliativos en zonas rurales

“No se trata de si su uso es ‘bueno’ o ‘malo’, sino de reconocer que responde a una necesidad real: la necesidad de sentirse escuchado, comprendido y acompañado, incluso por una inteligencia no humana”, afirma.

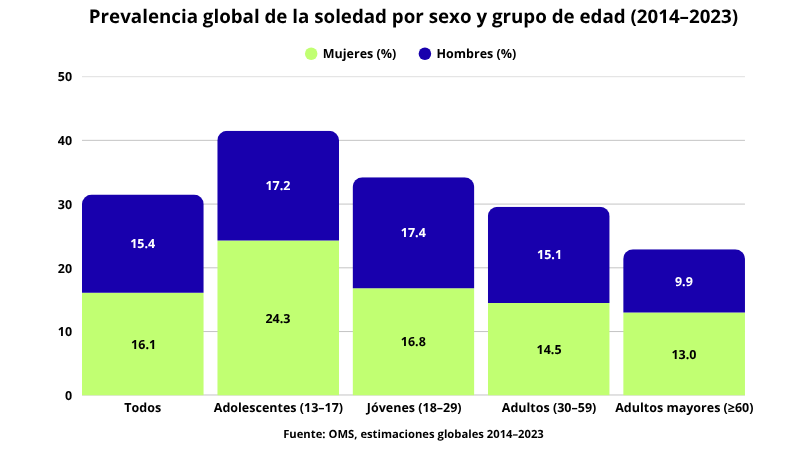

Según la Organización Mundial de la Salud (OMS), 1 de cada 6 personas en el mundo se ve afectada por la soledad, un sentimiento que, cuando se prolonga, puede tener consecuencias graves para la salud física y mental. Se estima que más de 870.000 muertes anuales están asociadas a este fenómeno. Y si bien las tecnologías digitales ofrecen posibilidades de conexión, también plantean riesgos si reemplazan los vínculos humanos. En esta tensión se mueven muchas de las preguntas actuales sobre inteligencia artificial y salud mental.

Entre oportunidades y límites

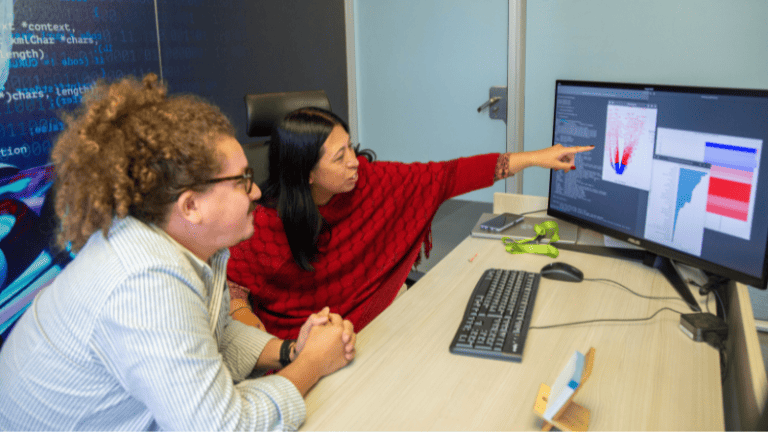

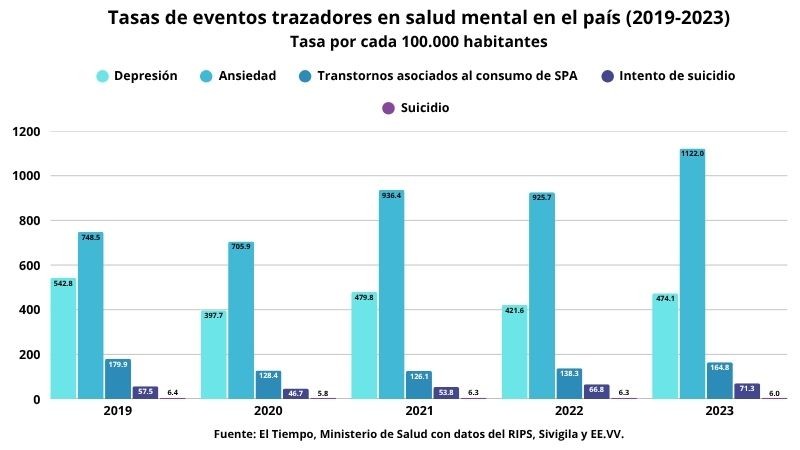

En un país como Colombia, donde el acceso a servicios de salud mental sigue siendo desigual, la IA puede jugar un papel importante en la prevención y detección temprana de riesgos.

“La IA puede ser una herramienta poderosa para ampliar la cobertura y reducir barreras estructurales en salud mental, particularmente en un país como Colombia, donde la distribución del talento humano en salud es desigual y los tiempos de atención suelen ser insuficientes”, señala la docente Castro.

Sin embargo, también advierte que estamos lejos de reemplazar la atención humana. El acompañamiento emocional profundo requiere empatía, comprensión contextual y una capacidad de contención que, por ahora, sigue siendo exclusiva de las relaciones humanas. La IA puede complementar, pero no sustituir. Además, su implementación conlleva riesgos que deben gestionarse con responsabilidad: sesgos algorítmicos, baja precisión, dificultades de interoperabilidad y falta de regulación clara.

También te puede interesar: Cómo proteger tu marca en el exterior: lecciones del caso Frisby

¿Qué se está usando y qué tan efectivo es?

Actualmente existen múltiples herramientas tecnológicas aplicadas a la salud mental: aplicaciones móviles con ejercicios de autocuidado, plataformas de terapia digital, chatbots conversacionales y programas de realidad virtual para intervenciones específicas, como fobias o trauma. Algunas muestran resultados prometedores en contextos de bajo riesgo, como mejoras en el estado de ánimo o reducción de síntomas leves de ansiedad.

Pero la evidencia también advierte sobre los retos. “La literatura indica una buena aceptación inicial de estas herramientas, sobre todo cuando están bien diseñadas, usan lenguaje accesible y ofrecen una experiencia personalizada. Lo que funciona mejor, según la evidencia, siguen siendo los modelos híbridos: tecnología más acompañamiento humano, no solo por eficacia, sino por confianza”, subraya la investigadora.

El riesgo de sentirse acompañado… por una máquina

Delegar el acompañamiento emocional a la IA sin supervisión puede generar confusión o incluso agravar el malestar. “Uno de los principales riesgos es la ilusión de contención emocional. Aunque los chatbots puedan simular una conversación empática, no experimentan emociones ni comprenden el contexto humano con la profundidad que implica un proceso terapéutico”, explica la profesora.

Además, está el riesgo de que las personas sientan que deben resolver solas sus dificultades porque “ya tienen una herramienta”. Esto puede aislarlas aún más. Por eso, insiste en que estas herramientas deben diseñarse desde el principio de no daño, con mecanismos de derivación claros, límites explícitos y advertencias sobre sus alcances.

¿Se están formando los futuros profesionales para estos escenarios?

En Colombia, los sistemas de salud aún no están plenamente preparados para integrar la IA en contextos reales de atención psicológica o psiquiátrica. La falta de regulación, las brechas de infraestructura digital y la baja formación en salud digital entre el talento humano son obstáculos evidentes. Y eso pone un reto importante en el campo universitario.

Consulta más sobre: Políticas migratorias de Estados Unidos: ¿qué deben saber los estudiantes?

Desde la perspectiva de la profesora Castro, las facultades de psicología deben liderar la discusión ética y formativa sobre estas tecnologías:

“No se trata solo de incorporar cursos técnicos, sino de formar profesionales capaces de entender las implicaciones éticas, sociales y clínicas del uso de estas tecnologías”.

Además, insiste en la importancia de generar evidencia local. “La formación en salud mental debe actualizarse no solo para entender la IA, sino para contribuir activamente a su diseño ético, inclusivo y centrado en la persona”, añade.

Conexión social, salud y dignidad

En mayo de 2025, la Asamblea Mundial de la Salud adoptó por primera vez una resolución sobre la conexión social como prioridad de salud pública. La OMS, en su informe más reciente, señala que la soledad y el aislamiento social tienen impactos comparables con factores de riesgo como el tabaquismo o la obesidad. Afectan la salud cardiovascular, aumentan el riesgo de ansiedad, depresión y suicidio, y tienen efectos económicos que se traducen en menor productividad y mayor gasto en salud.

Frente a este panorama, la docente Rubby Castro hace un llamado a promover una conversación pública más informada, que no caiga ni en el miedo ni en la idealización. “Promover una conversación pública equilibrada requiere tres cosas: evidencia, lenguaje accesible y participación diversa”, afirma y agrega que “el antídoto frente al miedo no es el optimismo ingenuo, sino la transparencia, el diseño participativo y la corresponsabilidad social en el uso de estas herramientas”.

Su mensaje para quienes están pensando en hablar con un chatbot es claro: puede ser un primer paso, pero no debe ser el único. “Un chatbot puede ayudarle a ordenar sus pensamientos, sentirse que algo ‘le escucha’ o aprender cosas nuevas sobre quién es. Pero no reemplaza una relación de confianza con una persona que pueda acompañar de verdad. (...) Y le diría que, si está pasando por algo difícil, que no se quede solo con el chatbot, que se lo cuente también a alguien de confianza, busque ayuda profesional si puede, o llame a una línea de atención”, concluye.

Más Noticias

Te puede interesar

Therian, salud mental e identidad: claves para entender el fenómeno viral

23 de Febrero de 2026

Comunicaciones

El debate sobre jóvenes que se identifican como animales crece en redes. Desde la salud mental explicamos identidad y trastorno clínico.

Programa Oruga se fortalece con más docentes y mayor alcance

12 de Febrero de 2026

Comunicaciones

Con el apoyo de la Facultad de Psicología y Bienestar Universitario, ampliamos la cobertura para acompañar a más estudiantes de primer semestre.

Celebramos el Premio Nacional de Psicología otorgado a la docente Yolanda Sierra

10 de Diciembre de 2025

Comunicaciones

La docente fue galardonada por el Colegio Colombiano de Psicólogos en la categoría Promoción y Divulgación del Conocimiento Psicológico.

El dolor lumbar no espera a la vejez: un desafío creciente en la vida laboral

21 de Noviembre de 2025

Comunicaciones

En el Congreso Interdisciplinario de Rehabilitación, especialistas abordaron el dolor lumbar y diversas patologías con enfoque interdisciplinario.

Del desprendimiento de retina a las gafas inteligentes en El Bosque

14 de Noviembre de 2025

Comunicaciones

En esta jornada del Programa de Optometría expertos hablaron de urgencias visuales y de tecnologías que devuelven la autonomía visual.

Universidad El Bosque lanza el primer Doctorado en Cuidados Paliativos de Latinoamérica

13 de Noviembre de 2025

Comunicaciones

Esta propuesta académica busca fortalecer la investigación científica en torno al sufrimiento humano, la atención integral y la calidad de vida.

ALMA: el prototipo de inteligencia artificial que mejoraría la lectura de citologías

23 de Octubre de 2025

Comunicaciones

El Bosque desarrolla una plataforma en fase alfa, que podría apoyar la detección temprana y reducir falsos negativos en cáncer cervical.

Docentes de El Bosque sobresalen en el Congreso Colombiano de Psicología

15 de Septiembre de 2025

Comunicaciones

Investigaciones en salud mental, psicología evolutiva, y redes académicas, entre otros temas, marcaron el aporte de los docentes de El Bosque.

Cómo prepararte para la Media Maratón de Bogotá sin poner en riesgo tu salud

24 de Julio de 2025

Comunicaciones

Desde la Especialización en Medicina del Deporte y de la Actividad Física de El Bosque compartimos recomendaciones para correr la Media Maratón.

Investigación revela brechas en cuidados paliativos en zonas rurales

09 de Julio de 2025

Comunicaciones

Las universidades El Bosque, La Sabana y el Observatorio Colombiano de Cuidados Paliativos revelan desigualdades en regiones apartadas de Colombia.

Vigilada Mineducación. Personería Jurídica otorgada mediante resolución 11153 del 4 de agosto de 1978.

Conéctate con la UEB

#ViveElBosque

Información de contacto

Instalaciones Bogotá

Av. Cra. 9 No. 131 A - 02

PBX: (601) 648 9000

atencionalusuario@unbosque.edu.co

Instalaciones Chía

Autopista Norte Km. 20 costado occidental Vía Chía - Bogotá

PBX: (601) 676 3110

Admisiones

Av. Cra. 9 No. 131A - 02,

Edificio Fundadores, Piso 1, Bogotá, Colombia.

Teléfono: (601) 648 9000 Ext.: 1170

WhatsApp: (+57) 311 512 8420

gestionadmisiones@unbosque.edu.co

Horario de atención

Lunes a jueves: 8:00 a.m. a 6 p.m.

Viernes: 8:00 a.m. a 5 p.m.

Sábado: 8:30 a.m. a 12:30 p.m.

Instalaciones Bogotá

Av. Cra. 9 No. 131 A - 02

PBX: (601) 648 9000

atencionalusuario@unbosque.edu.co

Instalaciones Chía

Autopista Norte Km. 20 costado occidental Vía Chía - Bogotá

PBX: (601) 676 3110

Admisiones

Av. Cra. 9 No. 131A - 02,

Edificio Fundadores, Piso 1, Bogotá, Colombia.

Teléfono: (601) 648 9000 Ext.: 1170

WhatsApp: (+57) 311 512 8420

gestionadmisiones@unbosque.edu.co

Horario de atención

Lunes a jueves: 8:00 a.m. a 6 p.m.

Viernes: 8:00 a.m. a 5 p.m.

Sábado: 8:30 a.m. a 12:30 p.m.

Información legal

- /sites/default/files/2025-04/Inscripciones.gifmain_menu_inscripcionscard-gif-sub-menu

- /sites/default/files/2025-04/Programas.gifmain_menu_programscard-gif-sub-menu

- /sites/default/files/2025-04/Facultad.gifmain_menu_facultiescard-gif-sub-menu

- /sites/default/files/2025-04/Vida%20Universitaria.gifmain_menu_universcard-gif-sub-menu

- /sites/default/files/2025-04/Nuestro%20Bosque.gifmain_menu_ubcard-gif-sub-menu

- /sites/default/files/2025-04/Investigaciones.gifmain_menu_investigationcard-gif-sub-menu